Czy zdarzyło Ci się kiedyś spędzić cały dzień na ręcznym kopiowaniu danych z jednego systemu do drugiego? A może Twoje dane w CRM i programie do faktur żyją własnym życiem, kompletnie się ignorując? Jeśli tak, to ten wpis jest dla Ciebie. Opowiem Ci o procesach ETL, czyli magicznym sposobie na zmuszenie Twoich systemów do rozmowy, oraz o tym, jak narzędzie n8n staje się w tym procesie Twoim najlepszym przyjacielem.

ETL, czyli Extract, Transform, Load, to w skrócie proces pobierania danych z jednego miejsca, przekształcania ich w pożądany format i ładowania do miejsca docelowego. Brzmi technicznie? Być może, ale w praktyce rozwiązuje bardzo przyziemne problemy biznesowe, oszczędzając masę czasu i eliminując błędy. A co najlepsze, dzięki narzędziom takim jak n8n, nie musisz być programistą, aby zacząć budować własne „rurociągi” danych.

Spis treści

- Czym tak naprawdę jest ETL i dlaczego n8n?

- Praktyczne zastosowania pipeline’ów ETL w biznesie

- Migracja danych między sklepami e-commerce

- Połączenie systemów CRM i ERP

- Automatyczne czyszczenie i normalizacja danych

- Jak zbudować podstawowy pipeline ETL w n8n?

- Twoje dane, Twoje zasady – podsumowanie

Czym tak naprawdę jest ETL i dlaczego n8n?

Wyobraź sobie, że przygotowujesz obiad. Najpierw wyciągasz składniki z lodówki (Extract), potem je kroisz, przyprawiasz i gotujesz (Transform), a na końcu wykładasz gotowe danie na talerz (Load). Proces ETL działa na identycznej zasadzie, tylko zamiast marchewki i ziemniaków operuje na danych.

- Extract (Pobierz) – to etap, na którym łączymy się ze źródłem danych. Może to być baza danych SQL, plik CSV, API sklepu internetowego czy arkusz Google.

- Transform (Przekształć) – tutaj dzieje się cała magia. Dane są czyszczone, formatowane, łączone z innymi danymi, a ich struktura jest dostosowywana do wymagań systemu docelowego. Na przykład zmieniamy format daty, łączymy imię i nazwisko w jedną kolumnę albo przeliczamy ceny z euro na złotówki.

- Load (Załaduj) – na ostatnim etapie przygotowane dane są wstawiane do systemu docelowego, np. do nowej bazy danych, systemu CRM czy hurtowni danych.

Dlaczego n8n jest idealnym narzędziem do tego zadania? Ponieważ łączy wizualny interfejs z potężnymi możliwościami. Pozwala budować skomplikowane procesy, przeciągając i łącząc ze sobą gotowe bloczki (nody), a gdy standardowe funkcje to za mało, zawsze można dopisać fragment kodu w JavaScript. To elastyczność, która demokratyzuje automatyzację danych.

Praktyczne zastosowania pipeline’ów ETL w biznesie

Teoria jest ważna, ale zobaczmy, jak ETL z n8n rozwiązuje realne problemy. Poniżej trzy scenariusze, z którymi spotykam się na co dzień, pomagając moim klientom.

Migracja danych między sklepami e-commerce

Zmiana platformy e-commerce, np. z PrestaShop na Shopify, to często koszmar logistyczny. Ręczne przenoszenie tysięcy produktów, klientów i zamówień jest nie tylko czasochłonne, ale też obarczone ogromnym ryzykiem błędu. Z n8n ten proces można zautomatyzować.

Pipeline ETL w tym przypadku mógłby wyglądać tak:

- Extract: n8n łączy się z API starego sklepu i pobiera listę wszystkich produktów wraz ze zdjęciami, opisami i wariantami.

- Transform: Dane są mapowane na nową strukturę. Nazwa pola „product_name” ze starego systemu staje się polem „title” w Shopify, a kategorie są przypisywane według nowej hierarchii. Można też przy okazji oczyścić opisy z niepotrzebnego formatowania HTML.

- Load: n8n, używając dedykowanego noda Shopify, tworzy każdy produkt w nowym sklepie, dodając do niego odpowiednie zdjęcia i przypisując go do kolekcji.

Dzięki takiemu podejściu migracja 10 000 produktów zamiast kilku tygodni pracy zespołu może zająć kilka godzin działania automatu, który można uruchomić w nocy, by nie zakłócać pracy biznesu.

Połączenie systemów CRM i ERP

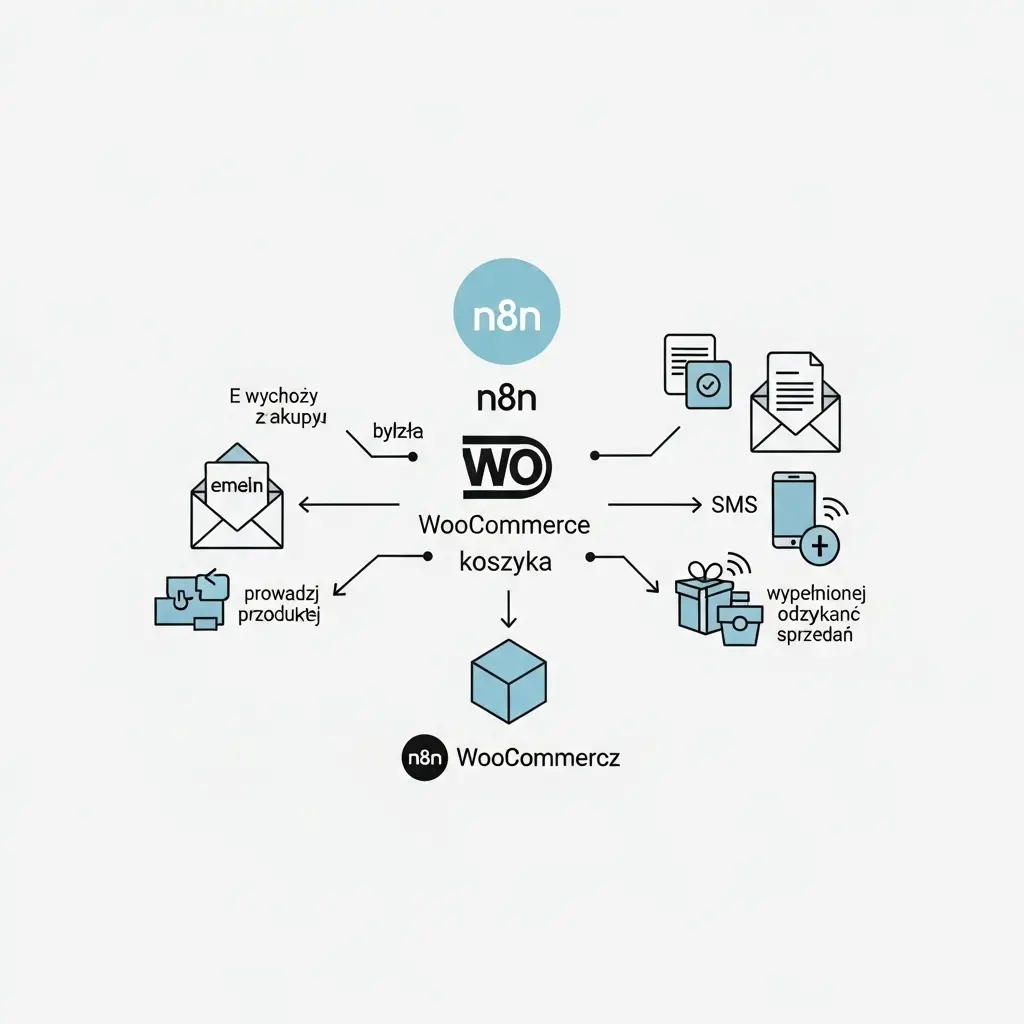

W wielu firmach handlowcy pracują w systemie CRM (np. HubSpot, Pipedrive), a dział księgowości w systemie ERP (np. Subiekt, Comarch ERP Optima). Brak synchronizacji między nimi prowadzi do chaosu – ręcznego przepisywania danych klienta, pomyłek w fakturach i braku spójnego obrazu sytuacji finansowej klienta.

n8n może działać jako most między tymi dwoma światami. Gdy handlowiec oznaczy szansę sprzedaży w CRM jako „wygraną”, n8n może:

- Extract: Automatycznie przechwycić to zdarzenie za pomocą webhoooka.

- Transform: Pobrać dane klienta i zamówienia, sprawdzić, czy NIP jest poprawny, a następnie przygotować dane w formacie akceptowanym przez API systemu ERP.

- Load: Utworzyć nowego klienta w ERP oraz wygenerować proformę lub zamówienie, a następnie wysłać handlowcowi powiadomienie na Slacku, że dokumenty są gotowe.

Automatyczne czyszczenie i normalizacja danych

„Śmieci na wejściu, śmieci na wyjściu” – ta zasada w świecie danych jest święta. Jeśli Twoje bazy są pełne literówek, różnych formatów zapisu (np. numerów telefonu jako „+48 123-456-789” i „123456789”) czy niekompletnych adresów, to żadne analizy i raporty nie będą wiarygodne. n8n jest świetny do „sprzątania”.

Możesz zbudować workflow, który cyklicznie:

- Extract: Pobiera dane z bazy danych lub pliku, który właśnie został wrzucony na serwer FTP.

- Transform: Za pomocą prostych operacji lub fragmentów kodu JavaScript:

- Ujednolica wielkość liter w imionach i nazwiskach (np. „jan kowalski” -> „Jan Kowalski”).

- Usuwa białe znaki i symbole z numerów telefonów, sprowadzając je do formatu „48123456789”.

- Waliduje poprawność adresów e-mail.

- Dzieli pełny adres na ulicę, numer domu, kod pocztowy i miasto.

- Load: Aktualizuje oczyszczone rekordy w bazie danych lub zapisuje je do nowego, czystego pliku.

Twoje dane, Twoje zasady – podsumowanie

Jak widzisz, procesy ETL to nie żadna czarna magia, a niezwykle potężne narzędzie do porządkowania i automatyzacji przepływu informacji w firmie. Dzięki platformom takim jak n8n, budowanie nawet skomplikowanych pipeline’ów staje się dostępne dla szerszego grona odbiorców. Zamiast tracić czas na ręczne przeklikiwanie, możesz skupić się na tym, co naprawdę ważne – na analizie danych i rozwijaniu biznesu.

Zautomatyzowana migracja, zintegrowane systemy i czyste, wiarygodne dane to fundamenty nowoczesnej, efektywnej firmy. Jeśli brzmi to jak rozwiązanie Twoich problemów, ale nie masz czasu lub zasobów, by się tym zająć, zapraszam do kontaktu. Na mojej stronie https://michalzareba.pl/ znajdziesz więcej informacji o tym, jak mogę pomóc Twojej firmie wejść na wyższy poziom automatyzacji.